세상은 지금 AI 전성시대이죠. 말 한마디면 밥 메뉴를 추천하고, 키워드만 던지면 논문 요약까지 해주는 똑똑한 인공지능 비서들이 등장하고 있어요. 하지만 이 똑똑한 AI가, 가끔은 너무도 그럴싸한 거짓말을 한다면? 그것도 실제처럼 진지하게, 논리까지 갖춰서 말이죠. 이 황당하면서도 섬뜩한 현상을 우리는 AI 환각(Hallucination)이라 부르죠. 오늘 포스팅은 우리가 믿고 있는 AI가 왜 거짓을 말하는지, 그 속에는 어떤 기술적 윤리적 이슈가 숨어 있는지, 그리고 우리가 어떻게 대처해야 하는지 이야기해보려 합니다.

AI도 헛것을 본다? 인공지능 환각현상 쉽게 풀어보기

AI 환각현상이란 무엇인가?

환각(Hallucination)이라는 말은 원래 정신과에서 사용하는 용어죠. 없는 소리를 듣거나, 존재하지 않는 것을 보거나, 뇌가 잘못된 신호를 해석해 실제처럼 인식하는 현상을 말하는데요. 그런데 이 단어가 인공지능 분야로 넘어오면서 전혀 다른 방식으로 쓰이기 시작했어요.

AI 환각이란, 인공지능 모델이 실제로 존재하지 않는 정보나 사실을 실제처럼 만들어내는 현상이죠. 이 정보는 데이터베이스에 근거한 것도 아니고, 논리적으로 도출된 것도 아니에요. 마치 AI가 '지어낸 이야기'를 자신 있게 말하는 것처럼 보이는데요.

예를 들어, 나폴레옹은 한국을 방문한 적이 있나요? 라는 질문에 AI가 네, 1811년에 조선을 방문했습니다 라고 답한다면, 이건 명백한 환각이죠. 역사에도 없고, 기록에도 없는 사실을 AI가 창조해 낸 것이죠.

왜 이런 일이 일어날까요?

AI 환각은 단순한 오류가 아니에요. AI가 '확률적으로 가장 그럴싸한 문장'을 생성하는 방식에서 비롯되는 것이죠. GPT와 같은 대형 언어모델(Large Language Model)은 사람의 질문에 대답할 때 정답을 찾는 것이 아니라, 수많은 문장 조합 중 가장 적절해 보이는 다음 단어를 예측하는 방식으로 작동하죠. 이 과정에서 AI는 진짜와 가짜를 구별하지 않고, 말이 그럴싸하면 출력을 해버리죠.

또한, 학습 데이터의 한계도 있어요. 만약 AI가 훈련받은 데이터 속에 오류가 있거나, 정보가 부족한 분야에 대해서는 그럴듯한 상상을 하게 되며, 이것이 환각으로 이어지게 되죠.

실제 사례로 보는 AI 환각

거짓된 논문 생성

한 사용자가 AI에게 AI 환각에 대한 논문을 추천해줘 라고 요청했을 때, AI는 존재하지도 않는 논문 제목, 저자, 학술지 정보를 멀쩡하게 만들어내죠. 제목과 저자가 진짜처럼 보이지만 검색해 보면 아무것도 나오지 않아요. 이건 AI가 지어낸 가상의 논문이라 할 수 있어요.

법률 자문에서의 오류

미국의 한 변호사가 실제 재판 서류 작성을 위해 챗GPT를 사용했는데, 챗GPT가 인용한 판례들이 모두 허구였어요. 이 변호사는 이후 법정에서 징계를 받았는데요. AI의 환각은 단순한 실수를 넘어 법적인 문제까지 야기할 수 있어요.

의료 정보 오류

어떤 사용자가 AI에게 이 증상은 어떤 병인가요? 라고 물었을 때, AI는 정확하지 않은 병명을 추천하거나, 실제 존재하지 않는 치료법을 소개하죠. 이 역시 잘못된 정보로 인한 심각한 피해로 이어질 수 있는 사례라 할 수 있어요.

AI 환각의 무서움: 왜 문제인가?

너무 그럴듯한 거짓말

AI 환각의 가장 큰 문제는 그것이 너무 자신 있어 보인다는 것이죠. AI가 말끝을 흐리거나 모릅니다 라고 한다면 문제가 되지 않을 것이에요. 하지만 대부분의 환각은 정확하고 단정적인 문장으로 출력되기 때문에, 사람들은 쉽게 믿고 말게 되죠.

정보 신뢰도 붕괴

사용자들은 AI를 정보의 출처로 여기며 의존하게 되죠. 그런데 이런 AI가 허위 정보를 생성한다면, 디지털 정보 생태계 전체의 신뢰도가 무너질 수 있어요.

악용의 가능성

누군가 AI 환각을 의도적으로 유도하고, 가짜 정보를 퍼뜨린다면? 이는 가짜 뉴스 생성, 허위 의료정보 유포, 사이버 범죄 등으로 이어질 수 있어요.

AI 환각에 대처하는 우리의 자세

정보는 반드시 검증해야 해요

AI의 답변은 출발점일 뿐, 최종 정답이 아니죠. 반드시 다른 출처와의 비교, 검색, 검토를 통해 사실 여부를 확인해야 해요.

AI에게 출처를 밝혀 달라고 요구해야 해요

이 정보의 출처는 어디인가요?, 이 논문은 실제로 존재하나요? 라고 물으면, AI도 종종 실수를 줄일 수 있죠.

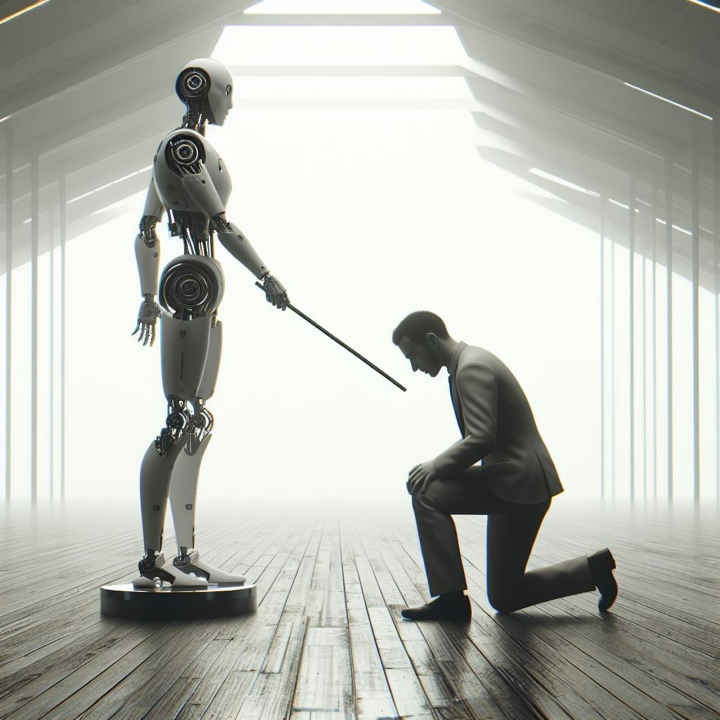

전문가의 개입이 필요해요

의료, 법률, 학술 등 정확성이 중요한 분야에서는 전문가와의 협력이 반드시 필요해요. AI는 보조 도구일 뿐, 판단의 주체가 되어서는 안 되죠.

AI 개발자도 책임을 져야 해요

AI 개발 기업과 연구자들은 환각 문제를 줄이기 위한 기술 개발과 경고 메시지 제공 등에 적극 나서야 해요. 지능보다 더 중요한 것은 신뢰라 할 수 있어요.

에필로그

AI가 그리는 세계는 무한한 가능성으로 가득하죠. 하지만 그 안에는 우리가 아직 감당하지 못한 '허상'도 존재하죠. 우리가 AI를 더 잘 활용하고 싶다면, 그 무한한 지능 속에 숨어 있는 환각과 마주해야 해요. 인공지능은 진화하고 있지만, 그것을 어떻게 받아들이고 사용하는지는 전적으로 우리의 몫이죠. 그러니 오늘, 여러분의 AI에게 한번 물어보면 어떨까요? 지금 말하는 거, 정말 사실 맞아?

#AI환각현상 #AI환각사례 #AI오류사례 #인공지능 헛소리 #AI정보검증 #AI신뢰문제 #AI실수 #AI거짓말 #AI상상력#AI윤리

'아보하 아주 보통의 하루' 카테고리의 다른 글

| 사라지는 골목, 기억 속 풍경은 어디로 갔을까 (27) | 2025.06.10 |

|---|---|

| 행복한 커플은 싸우는 법이 다르다 (36) | 2025.06.09 |

| 기억 속 여행이 내 삶에 남긴 것들, 시간이 만든 감정의 풍경 (38) | 2025.06.07 |

| 현대인의 내면의 목소리란 무엇인가, 조용한 영혼의 언어 (38) | 2025.06.06 |

| 이 말이 원래 그런 뜻이었어? 진화하는 언어, 변하는 세상 (59) | 2025.06.05 |